Linearna regresija

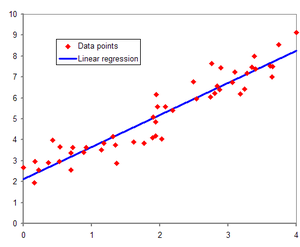

U statistici, linearna regresija se odnosi na svaki pristup modelovanja relacija između jednog ili više responsa (zavisnih promenljivih) označenog sa Y, i jedne ili više nezavisnih promenljivih označenih sa X, na način da takav model linearno zavisi od nepoznatih parametara procenjenih iz podataka.[1] Najčešće se linearna regresija odnosi na model u kojem je uslovna srednja vrednost od Y, uz datu vrednost X, afina funkcija od X. Slučaj sa jednom nezavisnom promenljivom se naziva jednostavna linearna regresija. Kad je obuhvaćeno više od jedne nezavisne promenljive, proces se zove višestruka linearna regresija.[2] Ovaj se termin razlikuje od multivarijantne linearne regresije, gde se višestruke korelisane zavisne promenljive predviđaju, umesto jedne skalarne promenljive.[3]

Mnogo ređe, linearna regresija se može odnositi na model u kojem se medijan, ili neki drugi kvantil uslovne distribucije Y za dato X izražava kao linearna funkcija od X. Kao i svi drugi oblici regresione analize, linearna regresija ima fokus na distribuciji uslovne verovatnoće od Y za dani X, a ne na distribuciji uslovne verovatnoće od Y i X, što je domen multivarijantne analize (engl. multivariate analysis).[4][5][6]

Linerana regresija je bila prvi tip regresione analize[7][8] koja je detaljno proučavana i koja se ekstenzivno koristila u praktičnim primenama.[9] Razlog za ovo je da se modeli koji linerano zavise od svojih nepoznatih parametara lakše modeluju nego modeli sa nelinearnom zavisnošću od parametara. Takođe, statistička svojstva rezultirajućih estimatora se lakše određuju.

Linearna regresija ima mnogo praktičnih primena. Većina aplikacija linearne regresije spada u jednu od sledeće dve široke kategorije:

- Ako je cilj predviđanje ili prognoza, linearna regresija se može koristiti za podešavanje preditivnog modela prema razmatranom skupu podataka vrednosti Y i X. Nakon razvoja ovakvog modela, ako je data vrednost za X bez pripadajuće vrednosti Y, model se može koristiti za predviđanje vrednosti Y.

- Ako je dostupna varijabla Y i veći broj varijabli X1, ..., Xp koje mogu biti povezane sa Y, može se koristiti linerana regresionu analiza za kvantifikovanje jačine relacije između Y i Xj, za procenu koji je Xj uopšte vezan za Y, te da bi identifikovalo koji podskupovi od Xj sadrže redundantne informacije o Y, tako da kad je jedan od njih poznat, ostali više ne daju korisne informacije.

Linearni regresioni modeli se često podešavaju uz pomoć metode najmanjih kvadrata,[10][11] iako se mogu koristiti i drugi načini, kao što je minimizovanje „nedostatka podešenja” (engl. lack of fit) u nekim drugim normama, ili minimizovanjem penalizirane verzije funkcije gubitaka najmanjih kvadrata, kao kod Tihonove regularizacije.[12][13][14]

Nasuprot tome, pristup metodom najmanjih kvadrata se može iskoristiti za podešavanje nelinearnih modela. Prema tome, pojmovi „najmanji kvadrati” i „linearni model” jesu usko povezani, ali nisu sinonimi.

Uvod

уредиUz zadati skup podataka od n statističkih jedinica, model linearne regresije pretpostavlja da se relacija između zavisne varijable i p-vektora regresora može približno uzeti kao linearna. „Približno” se ovde odnosi na „smetnje” εi — neposmatranu slučajnu varijablu koja dodaje šum u linearnu relaciju između zavisne varijable i regresora. Stoga, model ima oblik

gde je unutarnji produkat između vektora i .

Često su ovih n jednačina složene u vektorski oblik kao

gde je

Neke napomene vezane za terminologiju:

- je vektor izmerenih vrednosti ; se naziva regresand, zavisna varijabla, endogena varijabla, varijabla odgovora ili merena varijabla. Ova varijabla se ponekad naziva i predviđenom varijablom, ali to ne treba mešati sa predviđenim vrednostima, koje se označavaju sa . Odluka o tome koja se varijabla u skupu podataka modeluje kao zavisna varijabla, a koja kao nezavisna može se temeljiti na pretpostavci da je jedna od varijabli posledica ili pod uticajem druge varijable. Alternativno, može da postoji operacioni razlog za modelovanje jedne promenljive kao funkcije drugih, u kom slučaju nema potrebe za pretpostavljanjem uzročnosti.

- se može videti kao matrica od redova-vektora ili n-dimenzionalnih kolonskih-vektora , koji su poznati kao regresori, eksogene promenljive, promenljive objašnjenja, kovarijati, inputne promenljive, prediktorske promenljive, ili nezavisne varijable (ovo ne treba mešati sa konceptom nezavisnih randomnih promenljivih). Matrica se ponekad naziva matricom dizajna.

- Obično se konstanta uvrštava kao jedan od regresora. Posebno, za . Korespondirajući element β se naziva presek. Mnoge procedure statističke inferencije za linearne modele nalažu postojanje preseka, tako da se on obično uključuje čak i ako teoretska razmatranja sugerišu da njegova vrednost treba da bude jednaka nuli.

- Ponekad jedan od regresora može da bude nelinearna funkcija drugog regresora ili podatka, kao što je to slučaju u polinomskoj regresiji[15] i segmentnoj regresiji.[16] Model se smatra linearnim dokle god je linearan u pogledu parametra vektora β.

- Vrednosti xij mogu da budu bilo izmerene vrednosti slučajnih promenljivih Xj ili fiksne vrednosti izabrane pre merenja zavisnih promenljivih. Obe interpretacije mogu da budu podesne u različitim slučajevima, i generalno se koriste isti postupci procene; međutim u tim situacijama se koriste različiti pristupi asimptotskoj analizi.

Reference

уреди- ^ Seal, Hilary L. (1967). „The historical development of the Gauss linear model”. Biometrika. 54 (1/2): 1—24. JSTOR 2333849. doi:10.1093/biomet/54.1-2.1.

- ^ Freedman, David A. (2009). Statistical Models: Theory and Practice. Cambridge University Press. стр. 26. „A simple regression equation has on the right hand side an intercept and an explanatory variable with a slope coefficient. A multiple regression equation has two or more explanatory variables on the right hand side, each with its own slope coefficient”

- ^ Rencher, Alvin C.; Christensen, William F. (2012), „Chapter 10, Multivariate regression – Section 10.1, Introduction”, Methods of Multivariate Analysis, Wiley Series in Probability and Statistics, 709 (3rd изд.), John Wiley & Sons, стр. 19, ISBN 9781118391679

- ^ Mardia, KV; JT Kent & JM Bibby (1979). Multivariate Analysis. Academic Press,. ISBN 978-0-12-471252-2.

- ^ Feinstein, A. R (1996). Multivariable Analysis.. New Haven, CT: Yale University Press.

- ^ Johnson, Richard A.; Wichern, Dean W. (2007). Applied Multivariate Statistical Analysis (Sixth изд.). Prentice Hall. ISBN 978-0-13-187715-3.

- ^ Bishop, Christopher M. (2006). Pattern Recognition and Machine Learning. Springer. стр. 3.

- ^ Waegeman, Willem; De Baets, Bernard; Boullart, Luc (2008). „ROC analysis in ordinal regression learning”. Pattern Recognition Letters. 29: 1—9. doi:10.1016/j.patrec.2007.07.019.

- ^ Yan, Xin (2009), Linear Regression Analysis: Theory and Computing, World Scientific, стр. 1—2, ISBN 9789812834119, „Regression analysis ... is probably one of the oldest topics in mathematical statistics dating back to about two hundred years ago. The earliest form of the linear regression was the least squares method, which was published by Legendre in 1805, and by Gauss in 1809 ... Legendre and Gauss both applied the method to the problem of determining, from astronomical observations, the orbits of bodies about the sun.”

- ^ Bretscher, Otto (1995). Linear Algebra With Applications (3rd изд.). Upper Saddle River, NJ: Prentice Hall.

- ^ Stigler, Stephen M. (1981). „Gauss and the Invention of Least Squares”. Ann. Stat. 9 (3): 465—474. doi:10.1214/aos/1176345451.

- ^ Hoerl, Arthur E. (1962). „Application of Ridge Analysis to Regression Problems”. Chemical Engineering Progress. 58 (3): 54—59.

- ^ Foster, M. (1961). „An Application of the Wiener-Kolmogorov Smoothing Theory to Matrix Inversion”. Journal of the Society for Industrial and Applied Mathematics. 9 (3): 387. doi:10.1137/0109031.

- ^ Hoerl, R. W.; Kennard (1970). „Ridge regression: Biased estimation for nonorthogonal problems”. Technometrics. 12 (1): 55—67. JSTOR 1271436. doi:10.2307/1267351.

- ^ Yin-Wen Chang; Cho-Jui Hsieh; Kai-Wei Chang; Michael Ringgaard; Chih-Jen Lin (2010). „Training and testing low-degree polynomial data mappings via linear SVM”. Journal of Machine Learning Research. 11: 1471—1490.

- ^ Statistical significance of segmented linear regression with break-point using variance analysis and F-tests. Download from [1] under nr. 13, or directly as PDF : [2]

Literatura

уреди- Cohen, J., Cohen P., West, S.G., & Aiken, L.S. (2003). Applied multiple regression/correlation analysis for the behavioral sciences. (2nd ed.) Hillsdale, NJ: Lawrence Erlbaum Associates

- Charles Darwin. The Variation of Animals and Plants under Domestication. (1868) (Chapter XIII describes what was known about reversion in Galton's time. Darwin uses the term "reversion".)

- Draper, N.R.; Smith, H. (1998). Applied Regression Analysis (3rd изд.). John Wiley. ISBN 978-0-471-17082-2.

- Francis Galton. „Regression Towards Mediocrity in Hereditary Stature,”. Journal of the Anthropological Institute. 15: 246—263. (1886). (Facsimile at: [3])

- Robert S. Pindyck and Daniel L. Rubinfeld (1998, 4h ed.). Econometric Models and Economic Forecasts, ch. 1 (Intro, incl. appendices on Σ operators & derivation of parameter est.) & Appendix 4.3 (mult. regression in matrix form).

- Pedhazur, Elazar J (1982). „Multiple regression in behavioral research: Explanation and prediction” (2nd изд.). New York: Holt, Rinehart and Winston. ISBN 978-0-03-041760-3.

- Mathieu Rouaud, 2013: Probability, Statistics and Estimation Chapter 2: Linear Regression, Linear Regression with Error Bars and Nonlinear Regression.

- National Physical Laboratory (1961). „Chapter 1: Linear Equations and Matrices: Direct Methods”. Modern Computing Methods. Notes on Applied Science. 16 (2nd изд.). Her Majesty's Stationery Office.

Spoljašnje veze

уреди- https://web.archive.org/web/20070420165256/http://homepage.mac.com/nshoffner/nsh/CalcBookAll/Chapter%201/1functions.html

- Investment Volatility: A Critique of Standard Beta Estimation and a Simple Way Forward, C.TofallisDownloadable version of paper, subsequently published in the European Journal of Operational Research 2008.

- Scale-adaptive nonparametric regression (with Matlab software).

- In Situ Adaptive Tabulation Архивирано на сајту Wayback Machine (2. мај 2009): Combining many linear regressions to approximate any nonlinear function.

- Earliest Known uses of some of the Words of Mathematics. See: [4] for "error", [5] for "Gauss-Markov theorem", [6] for "method of least squares", and [7] for "regression".

- Perpendicular Regression Of a Line at MathPages

- Online regression by eye (simulation).

- Leverage Effect Interactive simulation to show the effect of outliers on the regression results

- Linear regression as an optimisation problem

- Visual Statistics with Multimedia

- Multiple Regression by Elmer G. Wiens. Online multiple and restricted multiple regression package.

- CAUSEweb.org Many resources for teaching statistics including Linear Regression.

- [8] "Mahler's Guide to Regression"

- Linear Regression - Notes, PPT, Videos, Mathcad, Matlab, Mathematica, Maple at Numerical Methods for STEM undergraduate

- Restricted regression - Lecture in the Department of Statistics, University of Udine